Erweiterungen für den Browser erfreuen sich immer größerer Beliebtheit. Die zusätzlich installierbaren Add-ons können ebenfalls bei der SEO-Analyse von Websites behilflich sein. Durch diese kann ein schneller jedoch teilweise nur oberflächlicher Ãœberblick über eine Website gewonnen werden.

Für Google Chrome und Mozilla Firefox gibt es jede Menge Tools , um eine Website ein wenig zu analysieren.

SEOquake

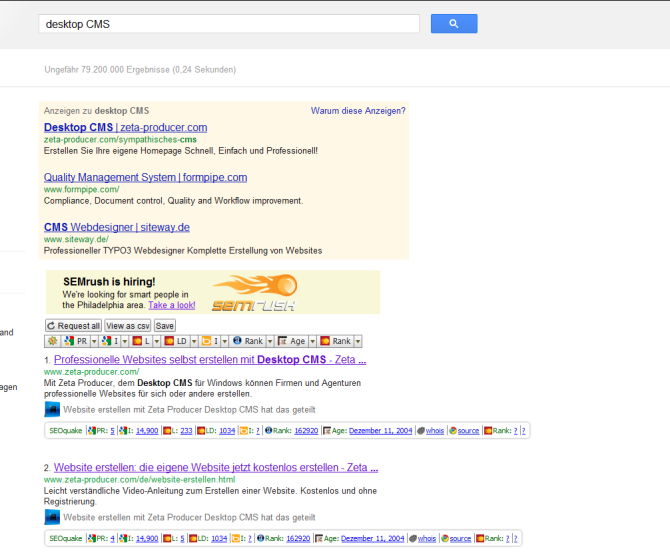

Das Seoquake Add-on ist sowohl für Google Chrome als auch für Mozilla Firefox erhältlich. Nach dem Download von der jeweiligen Website muss der Browser meist neu gestartet werden, damit das Add-On verwendet werden kann. Sowohl bei Mozilla Firefox als auch bei Google Chrome erscheint dann neben oder unterhalb der Suchleiste das entsprechend installierte Tool.

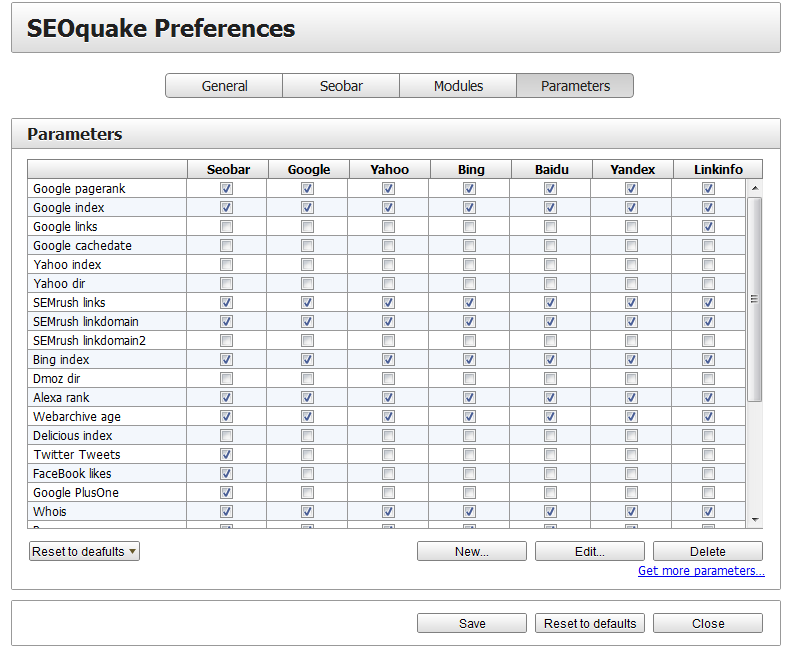

Bei SEOquake wird eine Vielzahl verschiedener Werte wie indexierte Seiten, PR, Alexa Rank und Domainalter angezeigt. Sollten Ihrer Meinung nach spezielle Werte zur Analyse einer Website fehlen, so besteht die Möglichkeit, dass mit einem Klick auf das Tool unter „Preferences“ bestimmte Parameter hinzugefügt oder entfernt werden können.Sollte die SEOquake-Leiste bei der Recherche über Google nicht bei jedem aufgelisteten Suchergebnis angezeigt werden sollen, so kann diese für verschiedene Suchmaschinen individuell unter „Preferences“-„Modules“ auf deaktiviert („disabled“) werden.

Sollte man nur zeitweise das Tool benötigen, so besteht die Möglichkeit, dass das Tool vorübergehend deaktiviert wird.

Mit dem Tool können innerhalb kürzester Zeit unter anderem folgende Werte eingesehen werden:

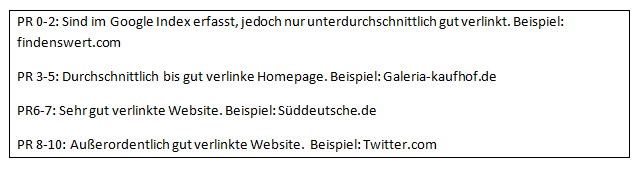

- PR

- Domainalter

- Empfehlungen über soziale Netzwerke

- Keyworddichte einzelner Wörter

- Anzahl Backlinks

- Alexa Rank

- Meta Keywords und Meta Description

- Interne und externe Links

- Anzahl der Domains im Google/Bing/Yahoo Index

Fazit

SEOquake ist ein sehr hilfreiches Tool, um sich innerhalb kurzer Zeit einen Ãœberblick über eine Homepage zu schaffen. Da es sich um ein kostenloses Tool handelt, muss man dabei auch Abstriche machen. Teilweise sind bei diesem Tool Werte nicht abrufbar und somit erscheint der Wert 0, obwohl der Wert momentan „lediglich“ nicht abrufbar ist.

SEO Site Tools

Ein weiteres Add-On ist das SEO Site Tools aus dem Google Chrome Store. Dabei handelt es sich um ein Tool, mit dem man ebenfalls die wichtigsten Werte einer Seite erhält.

Gegliedert ist das Tool in 6 Kategorien:

- External Page Data

- Page Elements

- Social Media

- Page Terms/Tools

- Server/Domain Info

- Suggestions

Bei External Page Data erhält man Informationen rund um die Links, die Autorität und die Popularität der Website. Um genauere Informationen über die angezeigten Werte zu erhalten, kann man auf dafür angelegte Links klicken und erhält eine genauere Analyse der Werte.

Unter Page Elements kann man Informationen rund um die On-page Optimierung der Website einsehen. Dort werden die Einzelne, vom Websitenbetreiber bestimmten, Meta Keywords oder die Meta Description angezeigt. Diese Daten können für die Analyse von Konkurrenten hilfreich sein. Es kann herausgefunden werden, welche Begriffe mit den verschiedenen Tags (h1, h2, h3, ..) benannt wurden. Außerdem kann man erkennen, welche Wörter auf der Seite verlinken und wie die einzelnen Bilder benannt werden.

Bei dem Reiter Social Media wird die Nutzung sozialer Netzwerke für die Website erkannt und dargestellt. Es wird ermittelt, wie viele Facebook- Likes und Twitter- Tweets die jeweilige Seite hat.

Page Terms/Tools verlinkt zu verschiedenen kleinen Anwendungen mit der zum Beispiel die Keyworddichte oder die Ladezeit der Website ermittelt werden kann.

Server /Domain Info gibt Aufschluss darüber, bei welchem Anbieter die Domain registriert ist und wer der Besitzer (inklusive Adresse) dieser Domain ist.

Unter Suggestions werden Vorschläge gemacht, wie die Domain suchmaschinenoptimiert werden kann. Grün hinterlegte Felder bedeuten eine gute Optimierung der jeweiligen Empfehlung. Gelb weist darauf hin, dass dieser Aspekt noch besser optimiert werden könnte und rot weist auf eine schlechte Optimierung hin. Sollte man überlegen, ob man auf einer Seite einen Link platzieren will, so kann über „Link Quantity“ herausgefunden werden, wie viele Links die Seite bereits besitzt.

Fazit

Da dieses SEO-Tool auch kostenfrei angeboten wird, muss man in Kauf nehmen, dass Daten für manche Seiten teilweise nicht aktuell oder gar nicht verfügbar sind. Um sich nur oberflächlich über eine Seite einen Eindruck zu schaffen ist dieses Tool jedoch sehr hilfreich. Dadurch, dass man die gewünschten Werte bei Bedarf mit einem Klick auf die Lupe zugreifen kann, ist die Benutzung sehr komfortabel.

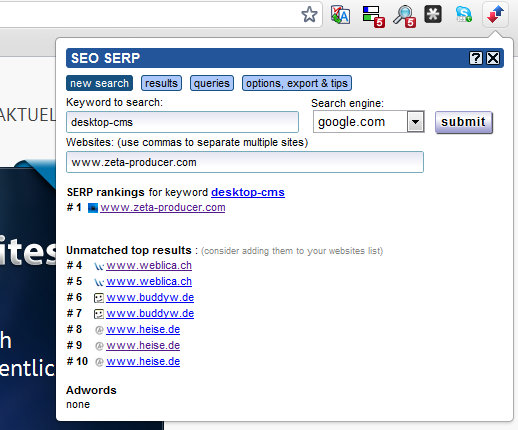

Will man lediglich herausfinden, mit welchen Keywords man bei Google an welcher Position rankt, so bietet sich SEO SERP als Add-on an.

Mit diesem Tool kann eine Suchanfrage simuliert werden. Nach Eingabe von Keyword, Suchmaschine und Website wird ermittelt, an welcher Position der Suchanfrage man gelistet wird. Sollte man die Suchanfrage über Google oder eine andere gewünschte Suchmaschine am Computer machen, so ist es möglich, dass die Ergebnisse durch andere Faktoren beeinflusst werden. (Da Suchmaschinen häufig den Ort des Computers lokalisieren, wäre es möglich, dass dementsprechend örtlich-nahe Ergebnisse angezeigt werden.) Zusätzlich werden noch Konkurrenten auf den obersten Plätzen der Suchanfrage angezeigt.

Für Nutzer von Mozilla Firefox ist SERPTrends SEO Extension eine Alternative.