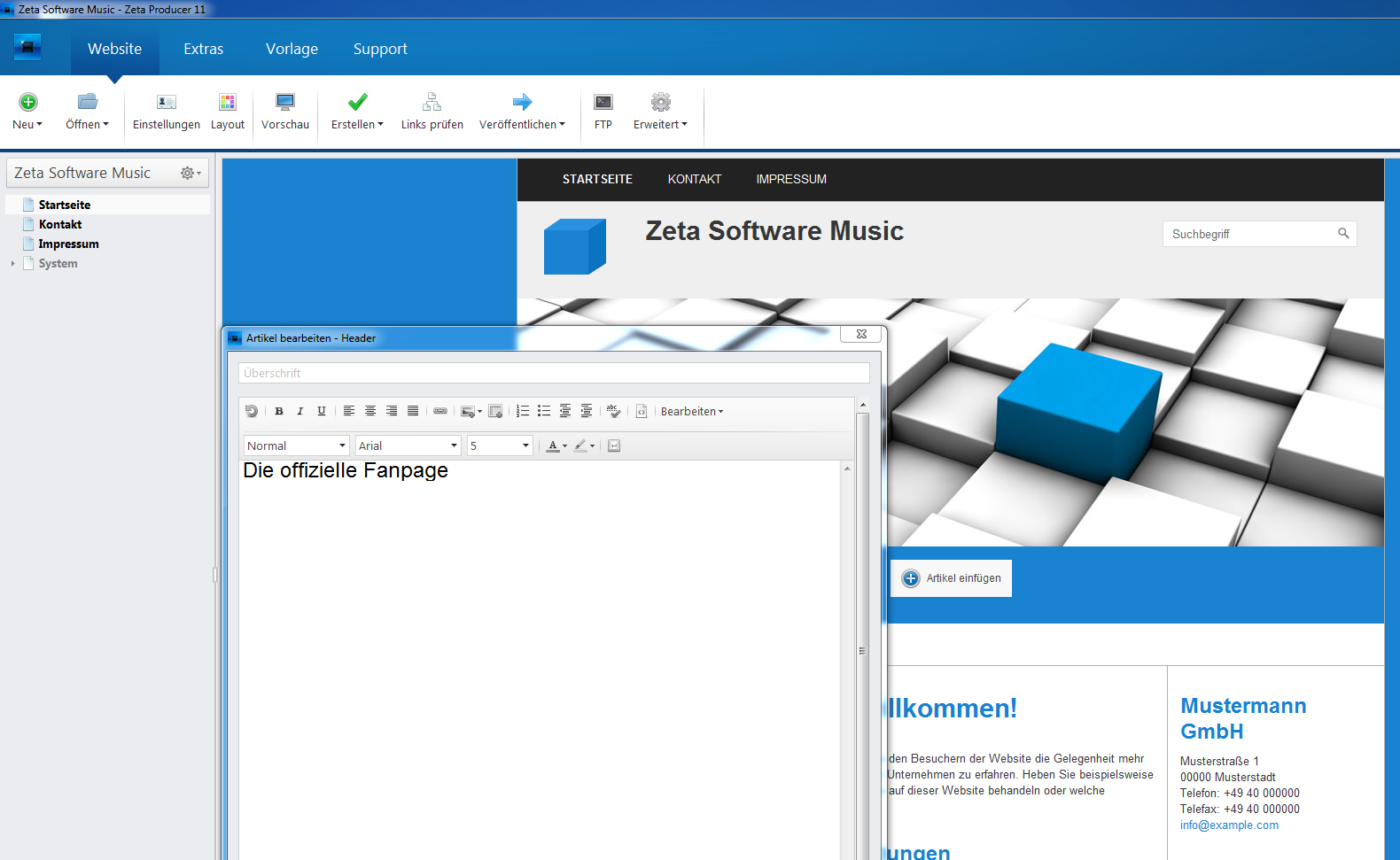

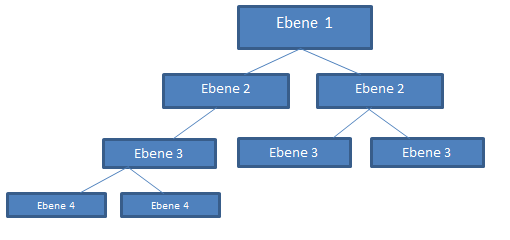

Der öffentliche Webauftritt ist heutzutage für viele Vereine, Organisationen oder Selbstständige eher die Regel als die Ausnahme. Wo früher noch professionelle Webagenturen beauftragt wurden, die Gestaltung der Internetpräsenz zu übernehmen, helfen heute Content Management Systeme (CMS). Ein CMS ermöglicht dem Laien seine eigene Homepage zu erstellen, ohne dass dieser im Besitz von Programmierkenntnissen sein muss.

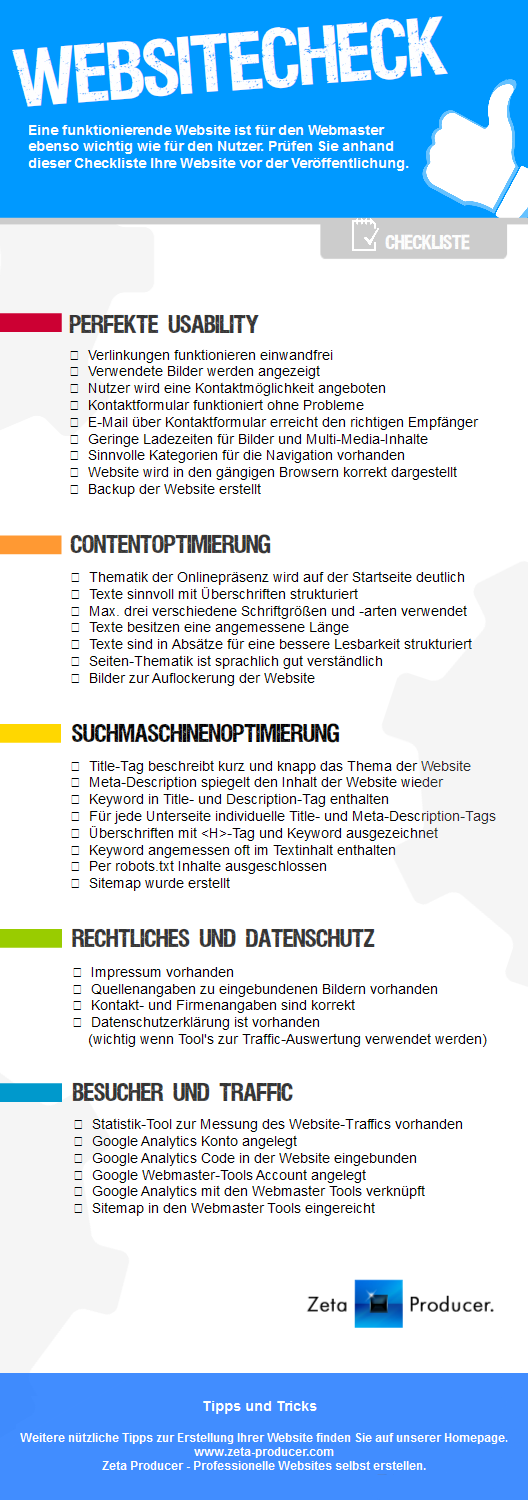

Bevor die Website veröffentlicht wird, sollte jedoch überprüft werden, ob die wichtigsten Punkte erfüllt sind.

Usability

Ihre Website sollte in den gängigsten Browsern korrekt dargestellt werden, lange Ladezeiten von Bildern und Multi-Media Inhalten gilt es zu vermeiden. Sollten Sie Hyperlinks auf Ihrer Website eingebunden haben, so vergewissern Sie sich, dass diese auch funktionieren. Für den Fall, dass ein Besucher mit Ihnen in Kontakt treten möchte, ist es ratsam, ein Kontaktformular standardmäßig in Ihre Webpräsenz einzubinden.

Content

„Content ist King“! Dieser Spruch ist immer wieder zu hören, wenn es darum geht, was eine erfolgreiche Website ausmacht. Fragen Sie sich deshalb vor jedem Eintrag, bietet diese Information einen Mehrwert für meinen Besucher?

Haben Sie passenden Inhalt gefunden und wollen diesen veröffentlichen, dann achten Sie darauf, dass ihr Artikel sinnvoll strukturiert ist. Aussagekräftige Überschriften und Absätze im Text helfen, den Artikel lesbar zu machen.

Lassen Sie den Artikel vor der Veröffentlichung von einem Freund oder Kollegen gegenlesen. Oftmals ist man selbst so in das Thema vertieft, dass es für Außenstehende schwierig ist, die Kernaussage zu verstehen.

Suchmaschinenoptimierung (SEO)

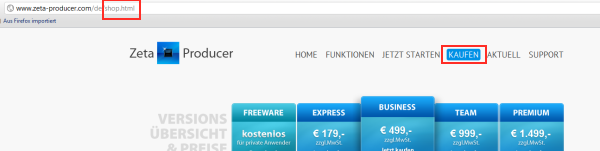

Sie haben eine interessante Website mit gutem Inhalt entworfen, aber keine besucht sie? Dann könnte es womöglich daran liegen, dass keiner Ihre Seite über eine Suchmaschine findet. Auch wenn Sie von Programmierung wenig Verständnis haben, so ist es doch sinnvoll, einen Blick in den Quelltext der Website zu werfen.

Überprüfen Sie Title-und Description Tags. Suchmaschinen bewerten den darin enthaltenen Inhalt und Kategorisieren diesen. Die Auswahl der richtigen Keywords ist hierbei von enormer Bedeutung.

Überschriften werden mit Hilfe von Tags, die von H1 bis H6 reichen, gegliedert. Achten Sie deshalb darauf, dass wichtige Keywords mit H1 und H2 deklariert sind.

Suchmaschinenoptimierung ist im Laufe der Zeit eine eigenständige Disziplin geworden. Diverse Schulungen helfen Ihnen, mögliche Defizite zu beseitigen.

Rechtliches und Datenschutz

Ihre Website ist keine rechtsfreie Zone: Alle Besucher müssen nachvollziehen können, wer die Urheberrechte für die Seite innehält. Impressum, Kontaktangaben und ggf. Urheberrecht der Bilder müssen auf Ihrer Homepage exakt angegeben und einfach auffindbar sein. Webdienste wie z.B. e-recht.de bieten hierfür einen Generator zur Erstellung eines rechtlich einwandfreien Impressums an.

Monitoring

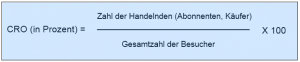

Wenn Sie sich die oben genannten Maßnahmen zu Herzen genommen haben, dann sollte ein Anstieg des Traffics zu verzeichnen sein. Überprüfen Sie Ihre Maßnahmen mit Tools wie Google Analytics und den Google Webmaster Tools. Das Monitoring ist jedoch keine einmalige Aktion. Es sollte in vorher definierten Zeiträumen festgelegt werden, wann eine Überprüfung stattfinden soll, um auf Unregelmäßigkeiten reagieren zu können.